A Nova Era da AI - 21/04/2025

O QUE ACONTECEU ESSA SEMANA?

Nova família GPT-4.1 da OpenAI voltada para desenvolvedores

Seaweed, a IA de vídeo eficiente da ByteDance

Kling AI lança novos modelos de vídeo e imagem

OpenAI lança os modelos o3 e o4-mini

Google Gemini 2.5 Flash com "orçamento de raciocínio"

DeepMind muda foco para o aprendizado de IA "experiencial"

Nova família GPT-4.1 da OpenAI voltada para desenvolvedores

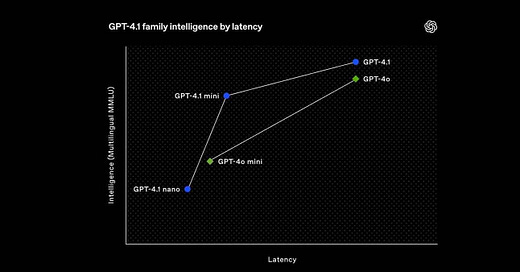

A OpenAI acaba de lançar o GPT-4.1, uma nova família de modelos disponível apenas via API, criada especificamente para desenvolvedores — com grandes melhorias em habilidades de programação, capacidade de seguir instruções e processamento de até 1 milhão de tokens de contexto.

A nova linha exclusiva para API inclui o GPT-4.1, 4.1 mini e 4.1 nano, superando significativamente o GPT-4o em tarefas essenciais para desenvolvedores.

Todos os três modelos suportam contextos de 1 milhão de tokens — o suficiente para até 8 bases de código completas em React — e ainda são 26% mais baratos que o GPT-4o em consultas típicas.

Os modelos também demonstram avanços em tarefas do mundo real, como desenvolvimento frontend, com avaliadores preferindo as interfaces web geradas pelo 4.1 em 80% dos casos comparado ao GPT-4o.

Os preços foram reduzidos em toda a linha: o GPT-4.1 é 26% mais barato que o GPT-4o, e o 4.1 nano aparece como o modelo mais rápido e barato da OpenAI até agora.

Seaweed, a IA de vídeo eficiente da ByteDance

A ByteDance apresentou o Seaweed, um modelo de geração de vídeo hiper-eficiente com 7 bilhões de parâmetros, que compete com modelos muito maiores como o Kling 1.6, Google Veo e Wan 2.1, apesar de utilizar significativamente menos recursos computacionais.

O Seaweed oferece diversos modos de geração, incluindo texto para vídeo, imagem para vídeo e síntese guiada por áudio, com vídeos de até 20 segundos.

O modelo se destaca em avaliações humanas em comparação com concorrentes e tem excelente desempenho em tarefas de imagem para vídeo, superando amplamente modelos como o Sora e o Wan 2.1.

Também é capaz de lidar com tarefas complexas, como narrativa com múltiplas cenas, movimentos de câmera controlados e geração audiovisual sincronizada.

A ByteDance afirma que o Seaweed foi ajustado para aplicações como animação de personagens humanos, com forte foco em movimentos realistas e sincronização labial.

Kling AI lança novos modelos de vídeo e imagem

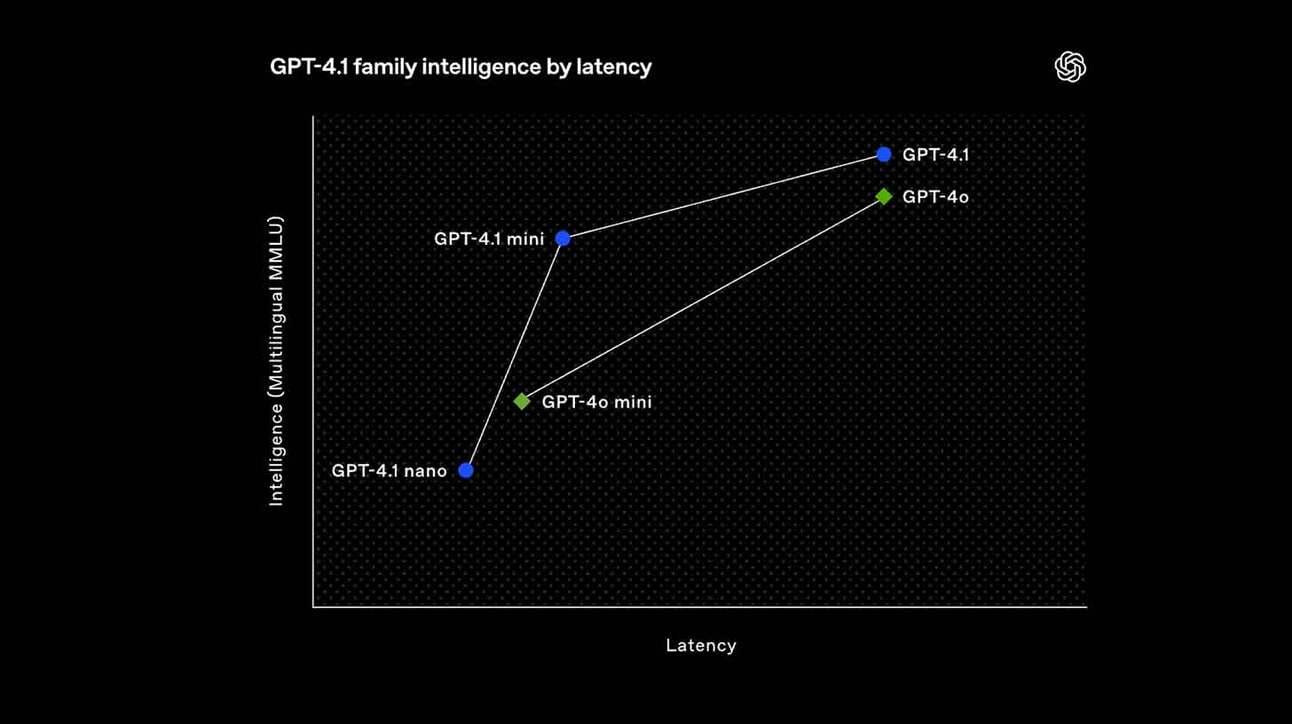

A startup chinesa Kling AI acaba de lançar uma grande atualização em sua suíte criativa, apresentando o KLING 2.0 Master para vídeos e o KOLORS 2.0 para imagens — com melhor aderência aos prompts, resultados mais realistas e novas funcionalidades de edição.

O KLING 2.0 Master agora interpreta prompts com ações e expressões em sequência, gerando vídeos cinematográficos com velocidade natural e movimentos fluidos.

O KOLORS 2.0 cria imagens em mais de 60 estilos, respeitando elementos, cores e posições dos sujeitos para resultados realistas, com profundidade e tonalidade aprimoradas.

O modelo de imagem também inclui novos recursos de edição, como inpainting (para editar ou adicionar elementos) e uma opção de restyle para alterar o estilo visual do conteúdo.

Separadamente, o modelo de vídeo 1.6 da Kling também está sendo atualizado com um editor de múltiplos elementos, permitindo que os usuários adicionem, troquem ou removam partes do vídeo a partir de comandos em texto.

OpenAI lança os modelos o3 e o4-mini

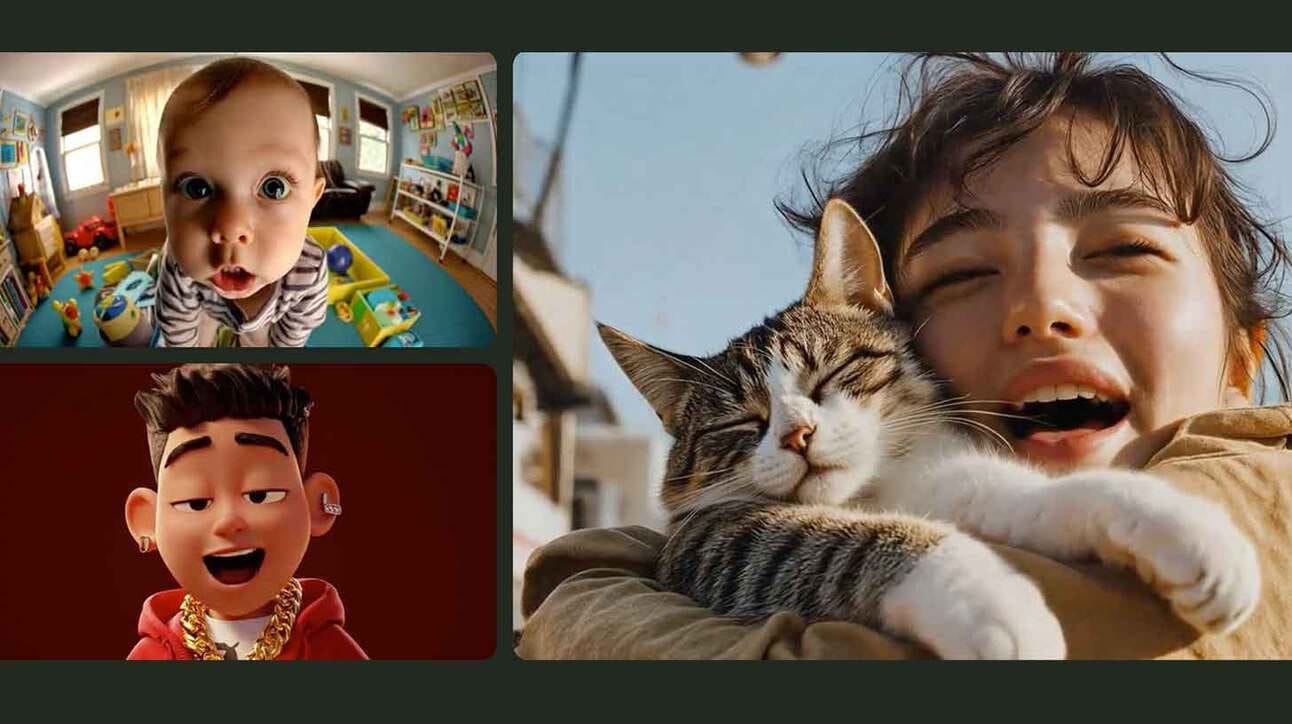

A OpenAI acaba de lançar o o3 e o o4-mini, seus modelos de raciocínio mais avançados até agora, equipados com acesso completo a todas as ferramentas do ChatGPT e com a capacidade de “pensar com imagens” — junto ao lançamento de um novo agente de programação open-source.

O OpenAI o3 é o novo modelo de ponta para raciocínio, elevando o desempenho SOTA (state of the art) em benchmarks de programação, matemática, ciência e tarefas multimodais.

O o4-mini oferece raciocínio rápido e econômico, superando significativamente os modelos mini anteriores e chegando a saturar benchmarks como o AIME 2025 em matemática.

Ambos os modelos podem usar e combinar todas as ferramentas do ChatGPT (busca na web, Python, geração de imagens, etc.) como parte do processo de resolução de problemas.

Esses são também os primeiros modelos capazes de “pensar com imagens”, integrando análise visual e manipulação diretamente em sua cadeia de raciocínio.

Também está sendo lançado o Codex CLI, um agente de programação open-source que roda no terminal do usuário e conecta os modelos de raciocínio a tarefas de codificação.

O presidente Greg Brockman afirmou que o lançamento representa “um salto qualitativo no nível do GPT-4 rumo ao futuro”, com os modelos sendo capazes até de gerar ideias científicas inéditas.

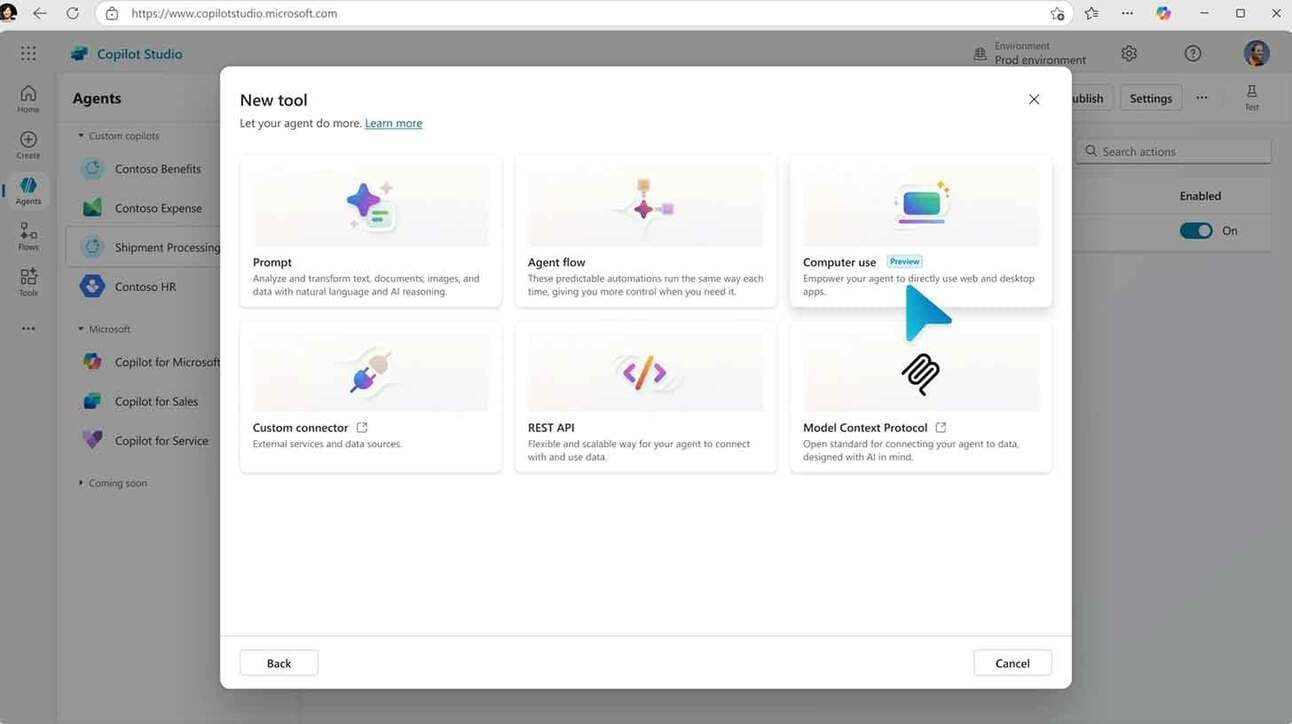

Copilot ganha capacidade de uso direto do computador

A Microsoft acaba de lançar uma nova funcionalidade de "uso de computador" no Copilot Studio, permitindo que usuários e empresas criem agentes de IA que possam operar diretamente websites e aplicativos de desktop.

A nova funcionalidade permite que os agentes interajam com interfaces gráficas de usuário (GUIs) clicando em botões, selecionando menus e digitando em campos.

Esse processo desbloqueia a automação de tarefas em sistemas que não possuem APIs dedicadas, permitindo que os agentes usem aplicativos da mesma forma que os humanos.

O Uso de Computador também se adapta em tempo real a mudanças nas interfaces, utilizando raciocínio embutido para corrigir automaticamente problemas e evitar que os fluxos sejam interrompidos.

Todo o processamento ocorre em infraestrutura hospedada pela Microsoft, com os dados empresariais explicitamente excluídos do treinamento do modelo.

Google Gemini 2.5 Flash com "orçamento de raciocínio"

A Google acaba de lançar o Gemini 2.5 Flash — uma IA híbrida de raciocínio em preview que iguala o o4-mini, supera o Claude 3.5 Sonnet em benchmarks de raciocínio e STEM, e introduz um novo "orçamento de raciocínio" para otimizar o custo versus qualidade.

O 2.5 Flash apresenta aumentos significativos de desempenho em raciocínio em relação ao seu antecessor (2.0 Flash), com um processo de raciocínio controlável para ativar ou desativar a funcionalidade.

O modelo apresenta um bom desempenho em benchmarks de raciocínio, STEM e raciocínio visual, apesar de ter um custo significativamente menor que os concorrentes.

Os desenvolvedores também podem definir um "orçamento de raciocínio" (de até 24k tokens), o que ajusta o equilíbrio entre qualidade de resposta, custo e velocidade.

Ele está disponível via API através do Google AI Studio e Vertex AI, e também aparece como uma opção experimental no aplicativo Gemini.

DeepMind muda foco para o aprendizado de IA "experiencial"

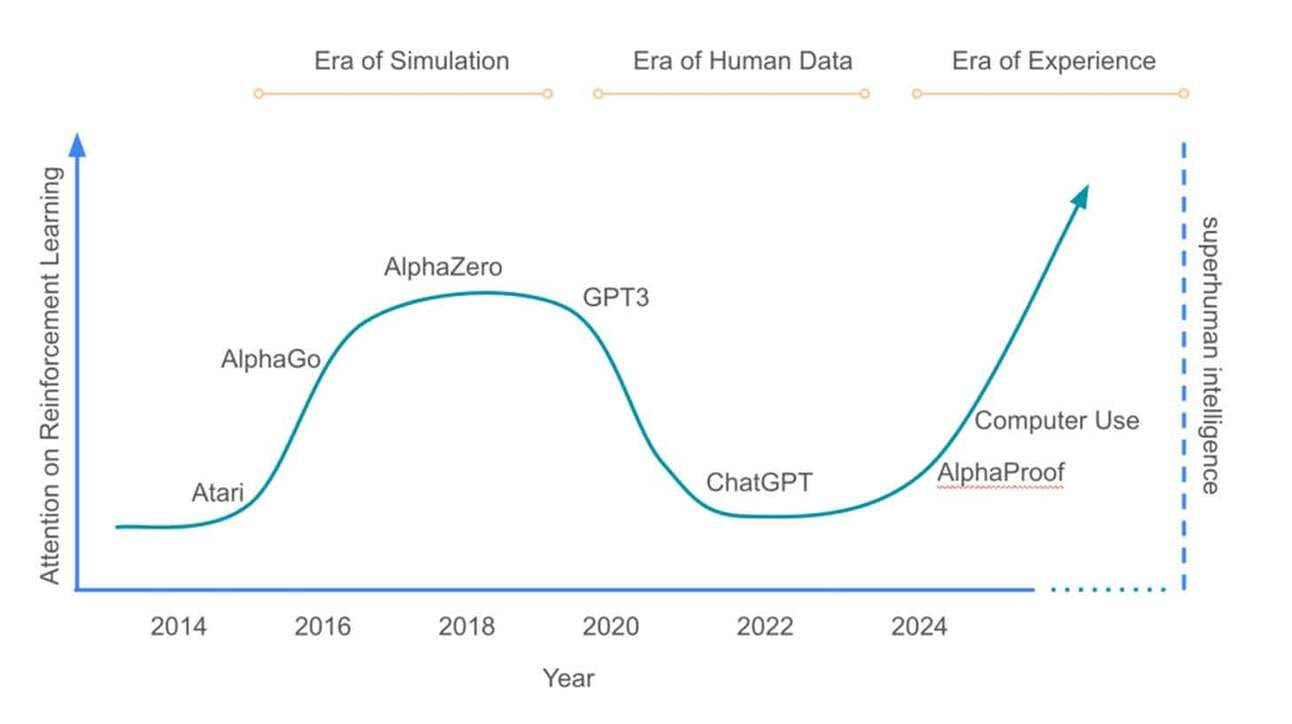

Pesquisadores da DeepMind publicaram o artigo “Welcome to the Era of Experience”, propondo um desenvolvimento de IA que vai além dos dados de treinamento gerados por humanos, com “fluxos” que permitem que a IA aprenda a partir de interações reais com o mundo e feedback ambiental.

Escrito pelas lendas de RL (Reinforcement Learning) David Silver e Richard Sutton, o artigo argumenta que o treinamento com dados humanos limita o potencial da IA e impede descobertas verdadeiramente novas.

Os fluxos permitiriam que a IA aprendesse de forma contínua, com interações prolongadas em vez de breves trocas de perguntas e respostas, possibilitando adaptação e melhoria ao longo do tempo.

Agentes de IA usariam sinais do mundo real, como métricas de saúde, notas de exames e dados ambientais, como feedback, em vez de depender de avaliações humanas.

A abordagem se baseia em técnicas que ajudaram sistemas como o AlphaZero a dominar jogos, expandindo-as para lidar com cenários do mundo real de maneira aberta.

Os pesquisadores sugerem que essa mudança poderia permitir que a IA descobrisse soluções além do conhecimento humano atual, mantendo, ainda assim, medidas de segurança adaptáveis.

ALGUMAS MENÇÕES RÁPIDAS:

LM Arena lançou o Search Arena Leaderboard para avaliar modelos de linguagem em tarefas de busca, com o Gemini-2.5-Pro da Google e o Sonar da Perplexity ocupando as primeiras posições.

Pesquisadores da Microsoft revelaram o BitNet b1.58 2B4T, um novo modelo de IA de 1 bit que iguala o desempenho de modelos maiores, enquanto roda de forma eficiente em CPUs.

A divisão de pesquisa FAIR da Meta acaba de publicar cinco novos projetos de pesquisa em IA open-source focados em percepção e raciocínio, destacando avanços em visão computacional, compreensão 3D e capacidades de IA colaborativa.

O novo modelo o3 da OpenAI obteve uma pontuação de 136 (116 offline) no teste de QI Mensa Noruega, superando o Gemini 2.5 Pro como a maior pontuação registrada.

Google lançou uma nova versão do Gemma 3 com "Quantization-Aware Training", permitindo que a versão de 27 bilhões de parâmetros seja executada em GPUs de consumidores, mantendo o desempenho.

Wikimedia Foundation, controladora da Wikipedia, fez uma parceria com o Kaggle da Google para publicar um conjunto de dados para desenvolvedores de IA, a fim de desencorajar a extração de dados da plataforma da empresa.

OpenAI introduziu uma nova opção de processamento Flex, que reduz pela metade os custos da API para os modelos o3 e o4-mini em troca de respostas mais lentas.